文丨財聯社

近一個月以來,AIGC現象級產品ChatGPT聊天機器人點燃、成就了一場資本狂歡。

可以說,ChatGPT的火爆,開辟了AI產業化的新路徑——以大模型敲開通用人工智能的大門。為了滿足大模型應用的巨大算力需求,大廠們紛紛加大了相關基礎設施方面的投資。作為算力基礎設施中的核心硬件,AI芯片由此進入人們的視野。

浙商證券最新報告表示,ChatGPT的“背后英雄”系GPU或CPU+FPGA等算力支撐,該應用對于高端芯片的需求增加會拉動芯片均價,量價齊升將導致芯片需求暴漲。信達證券也表示,AIGC推動AI產業化由軟件向硬件切換,半導體+AI生態逐漸清晰,AI芯片產品將實現大規模落地。

1月下旬以來,景嘉微、寒武紀、龍芯中科等多只個股漲幅已超30%。今日(2月9日)早盤,多只AI芯片股走強,截至午間收盤,景嘉微漲超16%,海光信息漲超14%,中科曙光、寒武紀、龍芯中科、安路科技等紛紛跟漲。

該AI芯片接棒了?

▌AI邁向大模型時代 芯片市場成長可期

ChatGPT的技術底座是“大型語言模型(Large Language Models)”,簡稱LLMs,中文習慣稱為“大模型”。算法是大模型成功的首要條件,然后要喂給算法海量的數據(數據量級躍升,能帶來更多能力的涌現),再搭配強大的發動機——大算力,才能獲得最基礎的大模型。

一個ChatGPT應用的算力消耗已經讓人瞠目。其大模型GPT經歷了三次迭代,GPT、GPT-2和GPT-3(當前開放的版本為GPT-3.5)的參數量從1.17億增加到1750億,預訓練數據量從5GB增加到45TB,其中GPT-3訓練單次的成本就已經高達460萬美元。最新的GPT3.5在訓練中使用了微軟專門建設的AI計算系統,由1萬個V100 GPU組成的高性能網絡集群,總算力消耗約3640PF-days,即假如每秒計算一千萬億次,需要計算3640天。

同樣,國產自研的源1.0、悟道和文心等AI模型,不僅在參數量上達到了千億級別,而且數據集規模也高達TB級別。想要搞定這些“龐然大物”的訓練,就至少需要投入超過1000PetaFlop/s-day(PD)的計算資源。

一言以蔽之,大模型為代表的AI新時代,算力便是核心競爭力。

而AI 芯片是針對人工智能算法做了特殊加速設計的芯片,也被稱為AI加速器或計算卡,是AI的算力基礎。要知道,ChatGPT有著大量復雜計算需求的AI模型,GPU、FPGA、ASIC等AI芯片專門用于處理這些計算任務,是不可或缺的底層硬件。

據了解,采購一片英偉達頂級GPU成本為8萬元,GPU服務器成本通常超過40萬元。對于ChatGPT而言,支撐其算力基礎設施至少需要上萬顆英偉達GPU A100,一次模型訓練成本超過1200萬美元。

浙商證券分析師陳杭據此表示,ChatGPT對于高端芯片的需求增加會拉動芯片均價,量價齊升將導致芯片需求暴漲,“目前OpenAI已推出20美元/月訂閱模式,初步構建了優質的訂閱商業模型,未來繼續擴容的能力將會大幅提升。”

中金公司認為,未來大模型趨勢下,AI芯片市場成長可期,在ChatGPT應用大規模商用初期,AI芯片行業有望創造20億美元左右市場空間。另據Omdia,2022年數據中心用AI芯片市場規模有望達133億美元。

▌多路線蘊含潛力 周邊生態有望受益

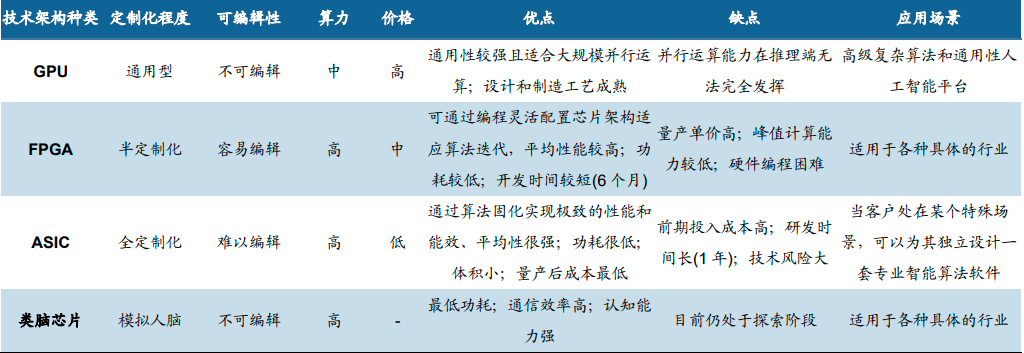

不過,在名為“AI芯片”的大籃子里,細分品類眾多。目前英偉達主導的GPU憑借高算力成為主流選擇,其他AI芯片如ASIC、DPU、FPGA也蘊含潛力——

ASIC/DPU等專用芯片在特定使用場景下高算力/低功耗/小面積的優勢仍吸引國內外廠商積極布局,如TPU、類腦芯片等;FPGA由于可編程而更具靈活性,相比于CPU/GPU/ASIC具有更高的速度和極低的計算能耗,常年來被用作專用芯片的小批量替代品。

AI 芯片根據技術架構分類

圖源:信達證券研報

多樣的技術路線也意味著,AI芯片的具體投資機會并不是那么好把握,英偉達這樣的巨頭也面臨被超車的風險。

信達證券便表示,AIGC的出現真正賦予了人工智能大規模落地的場景,AI芯片也將從過去面向廠商的訓練場景為主轉變為面向消費者的推理場景為主,GPU的高并行計算能力和高通用性的協調統一在消費者時代的統治力或許難以為繼,ASIC芯片、國產GPU芯片有望切入MaaS產業生態。

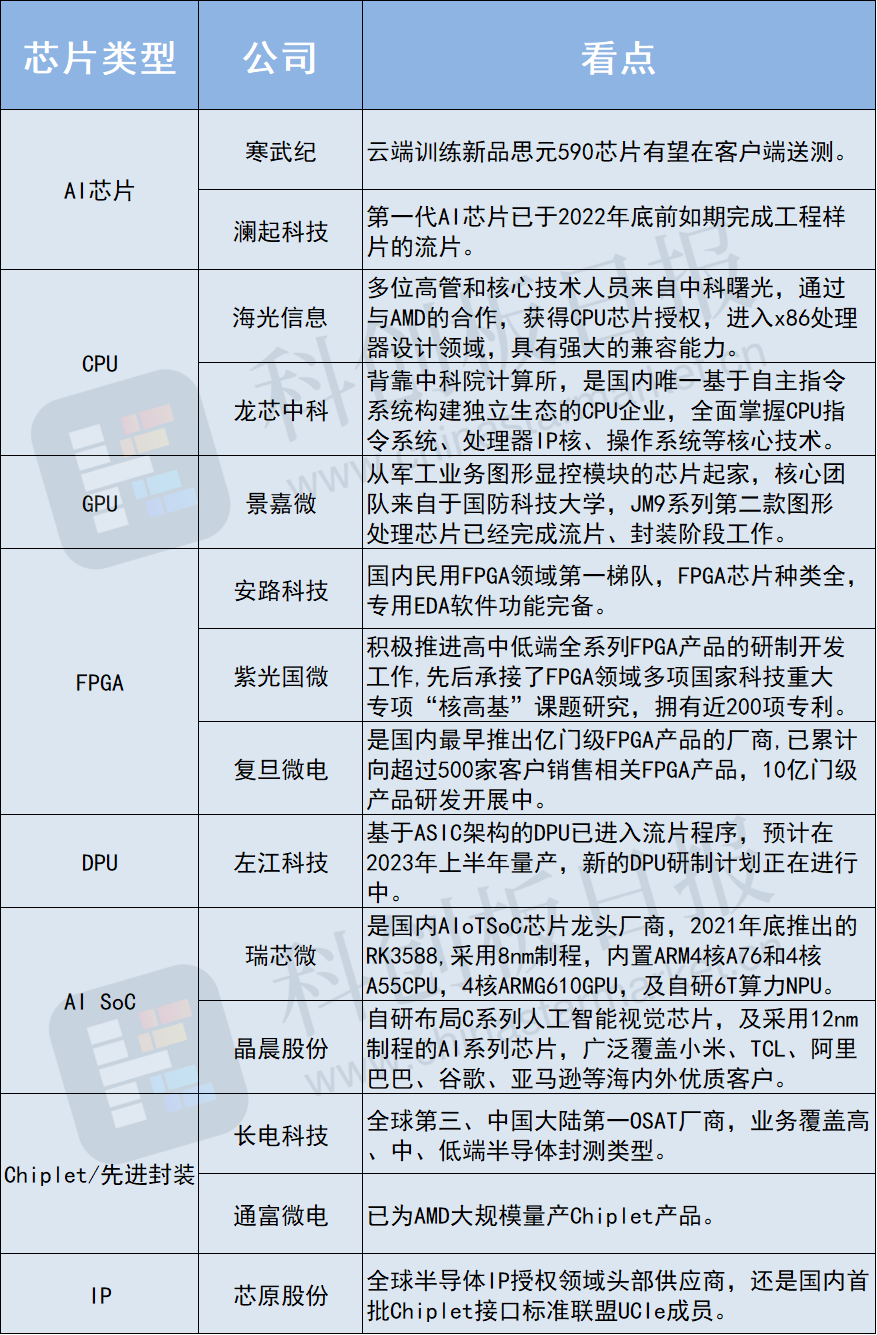

該機構進一步認為,AIGC推動AI產業化由軟件向硬件切換,半導體+AI生態逐漸清晰,AI芯片產品將實現大規模落地。硬件端核心包括AI芯片/GPU/CPU/FPGA/AI SoC等,而在AI芯片中,算力及信息傳輸速率成為關鍵技術,芯片性能及成本的平衡也帶動周邊生態,包括Chiplet/先進封裝/IP等產業鏈受益。

據《科創板日報》不完全統計,相關標的包括: