文 | 極智GeeTech

在1927年上映的《大都會》中,全世界第一部包含人形機器人的角色Maria誕生。

時隔60多年,人形機器人從電影走向現實。2000年,本田的ASIMO成為世界上最著名的人形機器人之一,它能夠行走、跑步甚至進行簡單的交流。如今,人形機器人浪潮正全面席卷而來。

2024年,在大模型的加持下,一個足夠性感的故事正在展開:長出“大腦”的人形機器人與科幻電影中通用機器人之間的差距正在縮短。在今年世界機器人大會上,27款人形機器人齊聚亮相,創歷屆之最。

作為人形機器人的內核,具身智能站在大模型和自動駕駛的臂膀上,其商業化進程要比預期來得更快。故事的書寫者們,已在具身智能領域內掀起一場諸神之戰。

具身智能 vs 自動駕駛

對于具身智能,并沒有一個嚴格的官方定義,其通常是指本體與智能體的結合,本體實現與物理環境的交互,感知環境做出行動,智能體通過環境信息持續學習賦予智慧,是包含人工智能、機器人本體、認知科學、神經科學等多學科交叉的系統。

2024年5月,英國自動駕駛獨角獸Wayve完成了10.5億美元C輪融資,這不僅是英國史上最大規模的AI融資,也是迄今為止全球排名前20名的AI融資之一。值得注意的是,Wayve聯合創始人兼CEO在完成融資當天寫下這樣一句話:“具身智能注定會成為最具價值的AI應用,未來還可能會改變我們與科技的交互方式。”

令人好奇的是,為什么一家自動駕駛公司要在融資當天提到具身智能,甚至還極為看好?

有人說,自動駕駛的存在是取代司機,具身智能的存在是要替代整個人類。當然,這只是跟隨如今互聯網風格的一種狹隘理解。自動駕駛與具身智能的真正相似之處是,從技術到底層邏輯的相似。而一種更好的理解則是,既然2024是自動駕駛的商業化元年,那么同樣地,它也見證了具身智能的“元年”。

根據全球頂級對沖基金Coatue發布的一篇關于“具身智能”的報告《The Path to General-Purpose Robots》(通往通用機器人之路),如果將具身智能的階段與自動駕駛的階段做類比,“過去無人駕駛汽車從L1到L2花了大約20年,而從L2到現在的L4只用了不到10年;那么人型機器人從L1到L2用了大約50年,從L2到L4預計只需要不到5年。”

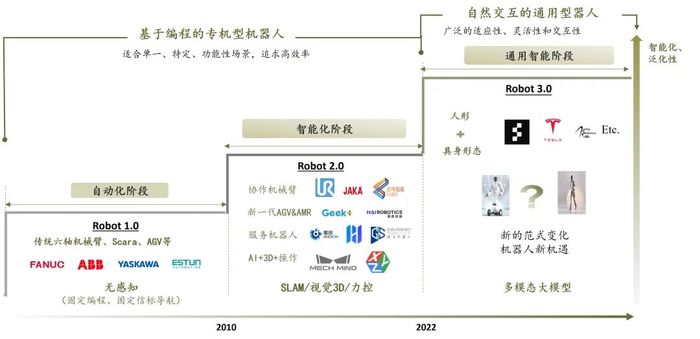

業界普遍認為,人形是機器人領域形態發展的最終目標,如果用自動駕駛的等級類比,即擁有高智能水平的人形機器人是L4。

與智能汽車類似,具身智能的實現包括“感知、決策、控制”三個主要環節,并需要內外部通信傳輸的支持。

感知是具身智能交互世界的窗口,首先要通過環境傳感器、運動傳感器收集環境與自身狀態信息,作為決策環節的依據;其次,要根據感知的信息以及任務目標,對自身行為進行規劃決策,并向控制模塊發出指令;之后,將決策指令轉化為實際操作,實現與物理世界的互動;傳輸方面則強調低時延、多連接、連續性能力。

從商業化的角度來看,具身智能與自動駕駛的發展路徑也或有高度擬合。以L2、L4區分,具身智能時代的人形機器人可以分為2種路徑:一種是在L2級別下逐步孵化出衍生的商業化產品,并且機器人的軀體形態也逐漸從輪式、足式、雙臂、到全身等等;而另一種則是L4級的打法,企業從一開始就只做人形機器人,直接求解最難的問題。通過大規模融資來穿越技術的發展周期。

自動駕駛的商業化有三類機會:首先是車本身,即L4自動駕駛技術的機會;其次是應用場景,即L2級別自動駕駛的機遇;最后是傳感器、毫米波、智能座艙等供應鏈技術。

清華大學智能產業研究院(AIR)院長張亞勤認為,無人駕駛將是未來五年內最大的物理(具身)智能應用,并且有望成為第一個通過“新圖靈測試”的具身智能系統。2025年將成為無人駕駛的“ChatGPT 時刻”,2030年無人駕駛成為主流,預計有10%的新車具備L4級別的自動駕駛能力。

對具身智能來說,機器人從局部到全身整體的蛻變過程,也會帶來三類機遇。

首先是機器人本體的開發,企業若有條件在初期就推出人形,自然能搶奪市場先機,讓后來者很難分一杯羹。

其次是場景機會,目前機器人的應用場景相對較少,但這也為行業提供了探索和發展的空間。

第三是產業上下游的機遇,上游包括智算中心的建設、算力芯片和端側模型等賦能機器人的關鍵技術;下游則涉及到各種傳感器、關節模組,它們相當于機器人的感官系統,包括視覺、觸覺和運動感知等等。

很顯然,在具身智能中,“上難度”的人形機器人代表著需要穿越周期的L4,甚至是L5。

“大腦+小腦”,大模型實現具身智能

從馬斯克到AI知名學者李飛飛,從英偉達、OpenAI甚至到國內幾乎所有科技大廠,全部紛紛涌入具身智能賽道,一致看好這個如今AI大模型加持下的機器人產業。

今年,人形機器人行業在具身智能領域取得了顯著的突破,基于通用大模型、數據集、高效計算架構、多模態融合感知等關鍵技術,為人形機器人安上聰明的“大腦”,使得人形機器人具備認知和決策能力,推動人形機器人走向實用階段。

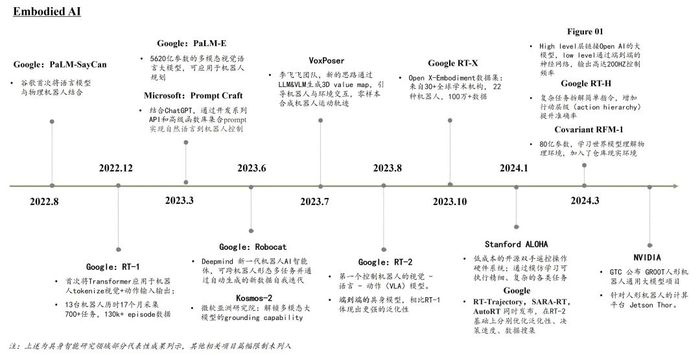

從大模型角度看,從最初的大語言模型(LLM),逐步邁向圖像-語言模型(VLM)乃至圖像-語言-動作多模態模型(VLA),這一轉變不僅意味著機器人將擁有更加豐富的信息處理能力,更預示著它們將能夠跨越語言與視覺的界限,實現更為復雜、靈活的交互方式。在這樣的技術背景下,人形機器人正朝著具身智能的終極目標邁進。

“具身”特點使具身智能大模型與通用大模型存在顯著差異。傳統具身智能的研究以深度學習范式為主流,通過模仿學習或強化學習技術訓練具身系統,使其習得技能。但傳統深度學習算法對數據集的依賴程度較高、遷移泛化能力較弱,對于訓練數據以外的技能執行起來較為困難。

大模型的出現為邁向通用人工智能提供契機。自谷歌Transformer神經網絡架構發布以來,眾多研究者發現基于Transformer的預訓練語言模型在非語言類的任務中也能取得不錯的效果,具有較強的泛化能力。此后大模型被引入具身智能領域,例如谷歌在2023年發布的PaLM-E模型,即是基于Transformer神經網絡開發的具身多模態大語言模型。

相較通用大模型,具身智能大模型需要更多地考慮感知的細度與廣度、與環境的交互性以及控制的協調性。

具身智能系統不僅要能夠準確地識別物體的類別和屬性,還要將視覺信息轉化為精確的空間坐標,以供機械臂、靈巧手等部位執行精細操作和關節控制。

同時,除文本、圖像、音頻、視頻等較為常見的模態數據外,具身智能還需要接收觸覺(如力的反饋、表面材質)、姿態(如空間坐標、位移距離、旋轉角度)等信息,以實現對環境更全面和準確的理解。

具身智能算法也需要理解物體的運動軌跡、事件的發展順序,才能做出及時而準確的決策。

環境交互是具身智能區別于其他有實體機器人的重要特征,通過與環境的交互,持續學習并更新知識,從而不斷提升算法性能。

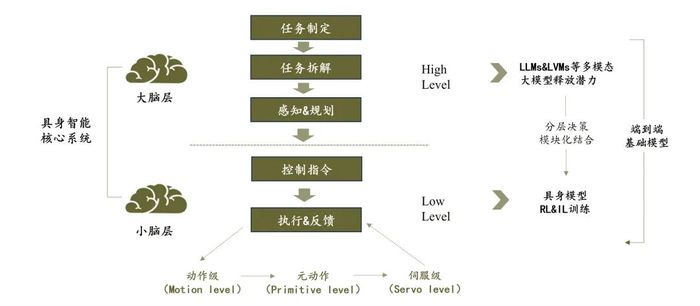

目前,人形機器人廠商主要采用分層端到端的方案,即通過“大腦大模型”和“小腦大模型”互相配合完成任務。

“大腦大模型”大多基于多模態通用大模型,完成對任務的感知規劃,再通過API調度“小腦大模型”驅動關節硬件完成執行。

例如優必選人形機器人Walker S接入百度文心大模型;智元機器人與科大訊飛簽署合作戰略協議,依托訊飛星火大模型進行聯合開發;樂聚機器人夸父搭載的是華為盤古大模型。

在“小腦大模型”方面,在技能應用上,智元機器人推出了通用的位姿估計模型UniPose、通用的抓取模型UniGrasp,通用的力控插拔模型UniPlug等一系列通用原子能力模型,可以配合大語言模型框架去做任務編排,使得機器人相比傳統協作機器人更容易部署,且具備一定的泛化能力。

優必選則從應用場景出發,集合了工業場景垂域大模型技術、計算機視覺感知、語義VSLAM導航、學習型全身運動控制、多模態人機交互等人形機器人全棧式技術,將人形機器人引入汽車產線的智能搬運、質量檢查和化學品操作等工位,推動人形機器人在汽車工廠的大規模應用。

值得注意的是,特斯拉Optimus使用完全端到端的神經網絡大模型,借助傳感器和計算機視覺技術,利用海量數據不斷優化訓練過程,直接生成關節控制序列。

在“小腦”操作大模型領域,各大廠商剛剛起步,多技術路徑同步發展。操作大模型決定了人形機器人在任務執行側的準確度,是大規模商業應用場景落地的前提。

數據成為第一大瓶頸

業內普遍認為,缺乏規模龐大且高質量數據是具身智能的發展難題之一。由于訓練機器人所需的物理數據不如文本數據量大且易獲得,相較于圖文大模型千億規模的數據訓練量,目前機器人數據集量遠不能滿足機器人達到通用大模型的需求。

目前,解決人形機器人訓練數據短缺的問題,一方面通過強化學習算法提高模型訓練效率,一方面則通過仿真平臺合成數據,建立數據開放生態。

數據對于訓練人形機器人具有至關重要的作用,它直接影響到機器人的感知能力、思考和決策能力以及行動執行能力。大模型通過大量數據學習,讓機器人理解任務意圖,并遷移到下游任務中,高質量訓練數據能夠有效提升人形機器人場景泛化能力。

在解決高質量具身智能數據不足的問題上,可以通過模擬環境合成數據輔助真實世界數據以豐富訓練數據來源,還可以構建更大規模、更多模態的共享數據集。

使用仿真及合成數據能夠降低數據收集成本并提高開發效率。合成數據的常見來源是借助大量符合現實世界物理規則的虛擬仿真場景學習技能和策略,后遷移到真實世界。與真實采集數據相比,基于仿真環境的合成數據具有采集成本低、采集速度快、可擴展性強、標注準確度高的優點。

共建高質量開源數據集,可以實現數據最大化利用。由于數據獲取的高成本、長周期以及隱私安全問題,大部分具身智能研究組織和企業僅限于在某個特定環境中收集數據,數據共享的缺乏導致重復勞動和資源浪費,形成“數據孤島”。

2023年,DeepMind與眾多科研機構展開合作,構建了真實機器人開源數據集Open X-Embodiment,包含22個機器人超過100萬個軌跡片段、500多項技能、16多萬項任務。基于此開源數據集訓練的具身智能控制基礎模型RT-X,表現出在跨場景、多任務應用中超越此前基于特定場景和數據集下的技能水平。

具身智能行至爆發前夜

從1973 年早稻田大學開發的世界上第一款人形機器人WABOT-1,到特斯拉的人形機器人Optimus、Figure AI的Figure 02,機器人的移動能力、操作能力、交互能力已經發生了巨大的變化,過去兩年,多模態大模型的加持,讓機器人借著具身智能的快速發展進入了一個新的階段。

2023年,行業新品迭出不窮,特斯拉、Figure AI,以及宇樹、智元、傅利葉等一批國產品牌集中在2023年推出首款人形機器人產品,銀河通用、加速進化、星動紀元等廠商紛紛成立,促成行業新品迭出的欣欣向榮之象。

行至2024年,優必選、Apptronik、特斯拉、Figure AI等公司開始陸續與汽車主機廠展開合作,將人形機器人落地汽車制造場景,初探商業化可能。

不過,目前絕大部分具身智能公司還處于不斷迭代的Demo階段,何時能夠將產品與某一場景很好地結合并商業化落地,是行業關心的重點問題。

根據中金研究院及研究部聯合研究發布的《AI經濟學》報告,從任務角度看,人形機器人“具身”的特點使其尤其適合力量型、靈巧型及空間移動導航等體力任務,例如上下料、維修、巡檢等。同時,其“智能體”特征使其具備人的智能與情感,能夠在教培輔導、服務接待、人文關懷等支持型任務中發揮作用,例如教育、講解導引、養老助殘等。

大部分行業都是由多類任務組合而成的,如果向終局去看,人形機器人有望在各個行業找到適合自身落地的應用場景。比如,服務業前臺(營業部客戶接待)、采礦業(物料挖掘搬運)、水電熱氣(電力巡檢)、看護養老業(康養陪護)、裝備制造業(工業制造)、醫療衛生業(手術機器人)、住宿和餐飲業(餐飲服務機器人)等等,不一而足。

可以說,人形機器人的滲透不會一蹴而就,隨著技術不斷成熟,人形機器人不僅能夠有更自然的交互性能,實現在交互要求更高的公共服務場景以及個人家用場景中的應用,還能提升對復雜場景的應對能力,進而開啟在高危、救援、多變環境下的滲透。總體趨勢是由專用場景向通用場景漸次滲透,最終實現在全行業各場景的落地。

具身智能時代的機器人,最終會擁有什么樣的形態?這個問題的背后,歸根結底是人類創造者對機器人的想象力。而無論是怎樣的想象,可預見的未來機器人或許都有類似的含義:一個在視覺、學習、決策等多維度擁有更高智能水平的機器人。

一個新的物種,正在硬件與智能的交互中誕生。