文|娛樂資本論 James

北京時間周二凌晨,蘋果公司發布了關于AI的最新更新,并給其AI功能取了一個雙關的稱呼:“果工智能”(Apple Intelligence)。在這次發布會上雖然沒有太多驚艷之處,但“隱私”這個概念被反復強調了十幾次。

即使如此,也有一位“資深網友”對此不以為然,這就是埃隆·馬斯克。

01 怒噴蘋果和OpenAI,馬斯克是否反應過度?

在蘋果發布會之后,馬斯克痛批蘋果與OpenAI之間的合作,認為這無異于將用戶的隱私信息毫無保留地轉手給OpenAI,并配了一張梗圖,稱蘋果作為用戶隱私被出賣給OpenAI的中間商。

他甚至提到,如果蘋果對ChatGPT是系統級別的集成,他將不允許員工將iPhone帶入特斯拉,如果訪客帶著iPhone進來,也需要把手機鎖在前臺的“法拉第籠”里面。

馬斯克本人(而不是高仿號)發表此言論后,大部分科技媒體都持不以為然的態度,指出他對于蘋果實現設備AI的方式缺乏足夠的理解。

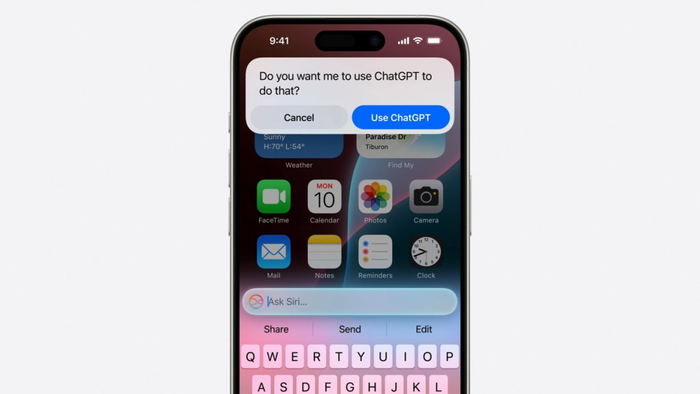

根據蘋果的官方演示,在Siri等地調動ChatGPT的方式,是首先會詢問用戶是否引用ChatGPT,在此之后代為做一次性的簡單查詢。這其中,ChatGPT就像網絡搜索一樣,只不過Siri之前調用搜索引擎,會帶來一大串雜亂的搜索結果,現在改為直接用GPT輸出一個段落的答案,感覺更好。

如果僅限于此,網傳Siri在中國的AI能力會被替換成百度的文心一言,那效果其實也不會差太多,因為這種自然語言替代主要是集中于搜索功能。其實,百度的AI搜索結果精選,效果比谷歌英文版的還好一些——后者因為奇葩結果太多,不得不臨時降低了在結果頁面的展示頻率。

蘋果推出的其他AI功能,依靠手機本身的芯片運算,或轉給蘋果自己的網絡端的大模型,這些運算并不依賴ChatGPT或其它第三方大模型。蘋果還指出,臨時需要上傳的數據會經過一個與目前iCloud等單獨分開的服務器,并隱藏相關可識別的用戶信息,甚至蘋果內部員工也無法訪問。

我們普通消費者也沒法證實蘋果的單方面陳述,但毋庸置疑的是,“隱私”現在確實是蘋果設備相對于Android等其他陣營的一個巨大賣點。特別是在后喬布斯時代,蘋果逐漸陷入創新乏力、“擠牙膏、割韭菜”的質疑聲音中。為了普通用戶難以感知的升級,每年多花幾千塊錢換新設備,這種必要性確實越來越受到質疑。所以,無論是否年年換新,一部分蘋果用戶寧愿舍棄微信雙開、通話錄音等便利,可能正是為了那份對隱私極度重視,帶來的安全和清靜的感覺。

馬斯克所說的質疑,更多其實是針對OpenAI一方表達不滿。馬斯克退出OpenAI管理層,之后又對其提起訴訟,其核心訴求在于讓OpenAI回到創業之初的非營利承諾,而不是只顧著賺錢。這一點比較抽象,但對馬斯克來說則是很重要的問題。與他持有類似觀念的還有OpenAI的“超級對齊”團隊,他們希望充分監管人工智能的發展,確保它不會失控。但該團隊在去年底的一次“宮斗”中失敗而解散。

這些爭論對于普通人是很難理解的。大家更關心的是,馬斯克的質疑是不是真實的?即使不是蘋果,其它AI大模型是否也很容易泄露用戶隱私?這一點迫切需要一個明確的答案。

02 使用AI大模型,會被“開盒”嗎?

簡單的回答就是,AI產品有可能發生隱私泄露,但截至目前,隱私泄露的成因是與AI無關的,更多是傳統的安全威脅。

我們使用AI出于個人或工作目的,所以害怕泄露個人隱私或工作機密。具體危害大小,分兩種情況:一種是泄露后能定位到你本人,直接“開盒”,另一種是無法溯源的泄露。

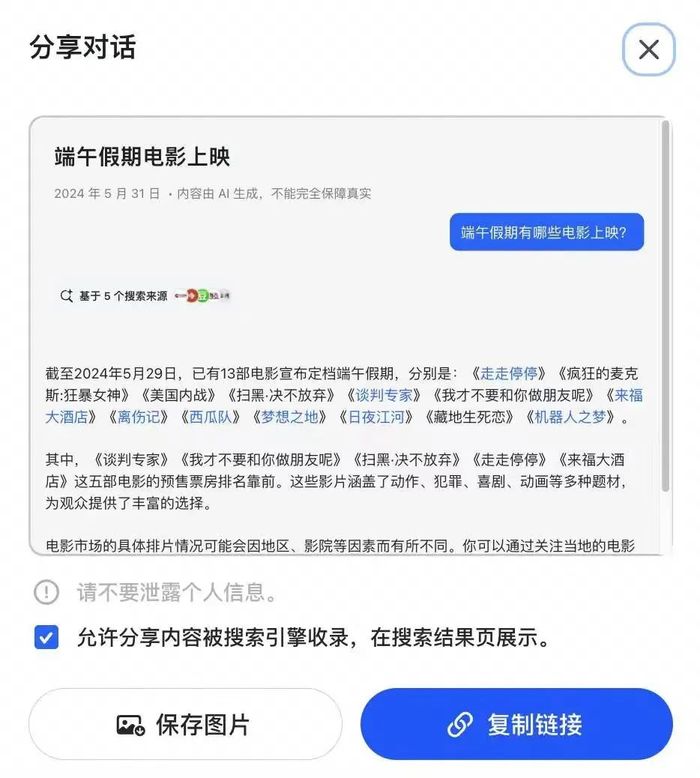

能定位本人的泄露情況最危險,這可能是因為你在疏忽大意的情況下勾選了某些選項,使原本私密的信息被設定為公開范圍分享。字節旗下大模型“豆包”近日的風波便是一例。

正如視智未來此前報道提到的,起初,豆包被指使用大量AI聊天結果頁面,污染搜索引擎結果。這種行為導致谷歌等搜索引擎,以及依賴它們的Perplexity等AI搜索產品,抓取的結果頁面也是AI生成的,導致AI自我引用,結果質量螺旋式下降。然而,字節此舉應該不是刻意污染互聯網環境,他們可能只是沒有意識到,對AI大模型使用同一招數時,事件的性質發生了改變。

豆包此舉最大的問題在于,這些分享的頁面來自真人用戶與豆包的交互過程。用戶分享某段豆包對話時,分享頁面會自動勾選“將對話內容分享到整個網絡”的選項,同時也沒有7天/30天有效期、鏈接帶密碼等常見的選項。在不注意的前提下,可能會讓你沒有察覺到“我本來只想把這段共享給我的微信群而已”。

當前,字節跳動已取消這種SEO嘗試,并下架了據稱多達2000多萬條的AI對話頁面。

可以定位到人的信息泄露還有其它情況。由于種種原因,我們可能需要與別人“拼車”使用ChatGPT、Midjourney等服務。使用這個賬號的歷史記錄也是共享的,所以你可以看到別人的工作內容,并且通過這些記錄與他本人對應起來。當一個共享賬號中長時間出現某家公司的具體信息,我們自然可以認為,其中涉及的未發布產品或戰略計劃等信息很可能是真實的。

另一種泄露情況是不可定位到發布者本人的,主要是指輸入的內容被用作訓練大模型,并在某種情況下被吐出。但這種情形一般都伴隨著嚴重的幻覺,所以幾乎不可能100%匹配你當時輸入的隱私內容。

在2023年ChatGPT剛剛興起時,軟銀、日立等多家大型日企出臺政策,禁止員工使用ChatGPT的公開服務。一些企業后來購買了企業版大模型服務,由官方承諾對機密內容的托管是安全的,甚至可以選擇在公司內的服務器部署。至于最近非常火的“AI PC”,其本質也是使用高算力芯片,將一些原本需要聯網的大模型運算改為本地生成,避免數據上傳到遠程服務器,而可能發生的泄漏情況。

以上兩種情況是與AI能力相關的隱私泄露風險,但這些問題發生的概率很低,并且只要更改使用習慣,也很大程度上可以避免。

03 更值得關注的隱私危機,不僅限于AI

與這些相比,真正值得注意的隱私泄露風險,發生在其他地方。

多數大模型開發商在數據收集、存儲和跨境傳輸等方面的安全保障能力有限。盡管國內的政策在大模型備案時,對其安全能力有基本要求,但客觀上,小公司或初創團隊的“技能樹”多點在了研發方面,在安全運營方面確實可能有所欠缺。需要指出的是,這方面的隱私泄露風險是普遍存在的,并不是只有AI公司才有的。

讓我們把視線轉回到嚴肅批評蘋果和OpenAI的馬斯克身上。既然他對隱私如此看重,他自己的產業是否有過隱私泄露的歷史呢?答案是肯定的。

特斯拉曾不止一次發生過用戶數據泄露風波,不過較大的幾次都是由于內部員工泄露所致。

在國內造車“新勢力”中,也有一些廠商曾收到職業黑客的敲詐勒索,或是公開了車主的信息數據庫等。這是國內眾多個人信息在暗網“倒賣”的案例之一。如果類似事情發生在AI工具中,那并不稀奇,但這些事故與AI技術的關系不大。

作為普通的AIGC用戶,我們要如何盡可能地保護自己,以避免隱私泄露的意外發生?

首先,按照蘋果官方的介紹,當你在使用iOS/macOS的AI相關服務時,這些過程很難向OpenAI等第三方泄露隱私。如果你之前信任蘋果的iCloud等服務,也可以繼續放心使用“果工智能”。

對于其他AI服務,在使用過程中,應盡量避免輸入個人和私密信息。即使使用Character.AI或類似的陪伴服務,它們必須通過讀取你的個人隱私來變得更懂你、更貼心,你也需要保持警惕。

在拼車使用ChatGPT等賬號時,如果是為公司工作,最好在輸入過程中隱藏具體公司信息,可以使用一鍵替換的方式,并且在獲得生成結果后,立即刪除這段對話。可以通過將真實事件以“我有一個朋友”的方式轉述,使用化名或代號替代真實公司、產品和地域信息,盡量避免將真實信息告訴在線大模型。

在使用諸如AI Pin、Rabbit R1或Meta-雷朋太陽鏡等AI硬件時,它們希望你的輸入是多模態的,例如對著攝像頭問“這朵花是什么”。這種情況下,AI硬件可能要求24小時授權攝像頭和麥克風的訪問。這本身存在較高的隱私泄露風險,因此需要權衡安全性和便利性的利弊。

總體而言,使用AI服務就算不幸發生了隱私泄露,在目前,這也跟AI沒有特別的關系,而是任何一家互聯網公司都面臨的同樣的風險。了解這一點,可能會讓你更放心地繼續使用大模型等AI產品。