4月18日,Meta發布了最新開源模型Llama3,訓練該模型使用的GPU芯片H100數量是Llama2時候的8倍,AI訓練的算力競賽再次提速。

4月18日,Meta發布了最新開源模型Llama3,訓練該模型使用的GPU芯片H100數量是Llama2時候的8倍,AI訓練的算力競賽再次提速。

更多的GPU芯片意味著更多的算力,也意味著需要消耗更多的電力。

今年以來,幾位悉心研究AI的商界大佬們紛紛發表言論,暗示AI發展的盡頭是“缺電”。OpenAI首席執行官薩姆·奧特曼表示,AI技術消耗的電力將遠遠超出人們預期。而埃隆·馬斯克認為,按照人工智能每6個月就以10倍速度飆升的發展趨勢,電力供應會面臨前所未有的壓力。英偉達創始人黃仁勛則說,AI的盡頭將是光伏和儲能。

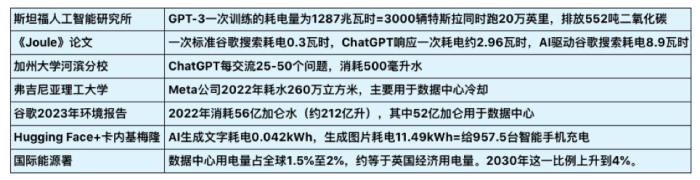

過去數據中心的快速發展,已經呈現出對電力和水資源的巨大需求,而AI將加速這一消耗。界面智庫整理已有的關于AI耗能、耗水量的研究,做了以下梳理:

“AI耗能”的問題還可以被拆解,其中包括軟件和硬件兩個部分。軟件指AI模型的訓練、使用耗能等環節,硬件指芯片、數據中心運轉的耗能。就以硬件中的芯片來說,芯片生產過程需要“超純水”清洗,耗水量巨大,有數據估算,生產一個2克重的計算機芯片大約需要32公斤水,臺積電每年晶圓產能約3000萬片,芯片生產耗水約8000萬噸。

打個不恰當的比方:軟件的耗能,類似一個人做一道數學題需要消耗多少腦力,懂得計算方法的人可能“用腦”更少;硬件的耗能,類似人體給大腦供能的效率,一個肌肉量高的人補充的能量可能有更大部分是被肌肉消耗掉了。而有觀點認為,AI之所以還沒有被普及,就是因為從目前的水平看,解決同樣的問題,從能耗和成本上,它還是比人腦“貴”多了。

當然,在AI耗能問題上,不能只看耗能不看產出,還要考慮到AI的廣泛應用能為各行各業帶來更大的生產力和發展潛能。

人工智能的能耗來自哪些環節?如何降低能耗以及未來如何填補用能缺口?界面智庫分別采訪了“軟件”和“硬件”方面的專家做出梳理和解讀。

一、生成式人工智能的耗能量和碳排放該怎么計算?能耗來自哪些環節?

一、生成式人工智能的耗能量和碳排放該怎么計算?能耗來自哪些環節?

清華大學工學博士、教授級高工、新型電力系統創新聯盟專家委員周文聞告訴界面智庫,生成式人工智能(AIGC)雖然是軟件模型,但按照全生命周期(LCA-Life Cycle Assessment生命周期評估)的計算方法,應該從開展和使用該算法業務的硬件部分開始計算,直到全生命周期結束。

如下圖所示,生成式人工智能的能耗組成部分包括:設備制造、模型訓練、數據標注、模型使用等四個環節。其中模型訓練是AIGC能耗的重要組成部分,其次是模型使用。

周文聞帶領團隊按照LCA的評估方法對某大模型進行碳足跡建模,其中設備制造階段重點計算了vCPU、內存和GPU的能耗(主動忽略了總線、接口、外設、風扇、機箱等);模型訓練階段只考慮了服務器的計算能耗和存儲能耗(忽略網絡傳輸);數據標注階段考慮標注所使用的筆記本/臺式電腦碳排放,模型使用階段和模型訓練階段的結算方式雷同,以能耗乘以碳排放因子來計算碳足跡,綜合得出的該大模型的產品碳足跡總量為962.37 tCO2e(二氧化碳排放當量),大概是49個美國人一年產生的碳排放(按美國人均二氧化碳排放量19.58噸計算-Maplecroft公司2009年數據)。

該公式沒有計算數據中心冷卻系統、網絡傳輸的碳足跡等。而事實上,數據中心的數據傳輸速率和散熱冷卻系統,也是重要的耗能來源。這些環節會如何影響數據中心能耗?

TE Connectivity是全球規模最大的連接和傳感解決方案提供商之一,TE Connectivity數據與終端設備事業部亞太區銷售總監蔣撲天告訴界面智庫,服務器的能效水平是影響數據中心能耗的重要因素之一。如果提高端到端整個鏈路上的數據傳輸速率,可以幫助數據中心降低服務器處理同等數據量的能耗,“比如理論上4G網絡條件下,每度電可下載620G的數據,而在5G每度電可下載2857G的數據,也就是說從能效上,5G是4G的4.6倍”。

他還指出,隨著數據中心算力提高,必然需要更高的能源電力,也就要求在不增加連接器產品空間的前提下,增加更多能源供應,這意味著連接器單位面積可承載的電源功率要相應提高。而當電源功率增加,單位面積不變大的情況下,散熱就非常關鍵。“所以在散熱方式上,國內從原來的風冷,現在開始嘗試做液冷,將熱能從模塊中傳輸出去,并保持較低的運行溫度,提高系統整體效率和可靠性。”蔣撲天說。

散熱就需要耗能。各家企業也在嘗試各種方法為數據中心散熱。中國宏觀經濟研究院能源研究所研究員崔成撰文寫到:微軟曾嘗試部署海下數據中心,Facebook數據中心選址在北極圈附近,阿里云千島湖數據中心使用深層湖水制冷等,我國很多企業則把數據中心布局在水電資源豐富的西南地區。

因此,生成式人工智能的能耗更準確的計算需要考慮軟件和硬件兩個部分以及不同環節。

二、Chatgpt、PaLM 、Claude、盤古、文心一言、Gemini,不同的大模型耗能是否會有差異?是否大模型越發展,就會消耗越多能源?

不同大模型的能耗確實會有差異。周文聞指出,其中設備制造環節的差異不大,因為不同大模型使用的硬件基礎設施大多是同質化的CPU和GPU服務器;而差異主要體現在模型訓練、數據標注、模型使用這三個環節。目前很少能從公開資料查到以上大模型的資源使用信息,在數據不透明的情況下(除了各家自己掌握數據),很難準確計算大模型的能耗使用水平。

不過,硬件基礎設施的能耗計算方式,也有可能因為技術革新而被顛覆。就在近日,媒體報道稱前谷歌量子計算團隊的幾位員工創立了一家名為Extropic的公司,提出用物質隨機波動驅動計算,認為這種計算方式更接近人類大腦,將有可能擴展硬件的性能界限,超越傳統的數字計算,比現在的CPU、GPU等數字處理器更高效更節能。

至于隨著大模型的發展,未來是否會消耗越多能源,周文聞指出,因為模型的迭代主要靠新的數據訓練來完成,數據訓練的基礎設施就是算力,而算力的基礎設施是能源。

舉個例子,因為與微軟工程師有過交流,AI創新公司OpenPipe的聯合創始人Kyle Corbitt在社交平臺X上回答提問“為何不將(GPT-6)的訓練集群集中同一個區域”,因為“有嘗試過,但無法在同一州放置超過10萬片H100的GPU,否則會導致電網癱瘓。”

“需要注意的誤區是,大模型消耗能源并不可怕,可怕的是大量消耗傳統能源,關鍵是要使用清潔能源來替代。”周文聞說。

華泰證券研報預測,到2030年中國與美國的數據中心總用電量將分別達到0.65萬億千瓦時至0.95萬億千瓦時、1.2萬億千瓦時至1.7萬億千瓦時,是2022年的3.5倍和6倍以上。解決用能問題,也是解決AI技術與產業未來發展的瓶頸。

三、未來如何填補缺口?通過哪些方式為人工智能供能?

“這個問題需要辯證看待。”周文聞指出,生成式人工智能發展的不同階段,對能源的需求是不同的,例如在目前LLM的形態下,當前的能源是夠用的,而按照OpenAI規劃的最終AI形態,能源基礎設施必須跟上,否則會制約AI技術的發展。

在未來增加供能方面,周文聞認為可以從供給側和需求側兩個方面解決。供給側:一是做好傳統能源向清潔能源逐步轉化、逐漸替代,人工智能的發展也要和化石燃料脫鉤;二是大力發展和建設清潔能源,比如風電、光伏、儲能,提高清潔能源占比;三是積極探索新型能源技術和相關新材料,比如可控核聚變、固態電池、鈣鈦礦等。

在需求側:一是減少重復的模型訓練工作,不同國家/廠商用同樣或類似的數據集訓練自己的閉源模型,造成能源重復浪費,應該鼓勵開源模型的應用,鼓勵共享部分模型和算法;二是積極探索和研究新的模型架構,在訓練完模型底座后,盡可能微調模型結構;三是人工智能公司也要有氣候變化的危機意識和能源危機意識,盡可能使用清潔能源。

蔣撲天則指出了兩項在硬件上有望節能增效的技術創新。

一是材料創新,在印制電路板(PCBA-Printed Circuit Board Assembly)里,探索“光進銅退”—即通過OTB(光纜終端盒)的方式用光纖替代一部分服務器里的銅線。

“過去’光進銅退’主要體現在終端設備外部,用光纜而不用銅纜進行長距離傳輸,幫助節省材料成本和電力消耗,未來的‘光進銅退’發生在設備內部,數據連接的傳輸速率在單次迭代的情況下,提升得越來越快。”他指出,在數據傳輸速率從224G到448G的發展過程中,很可能會發生“光進銅退”的變革,芯片到芯片之間以光纖的形式連接,減少原有芯片外部的電力驅動和電光/光電轉換環節,從而減少能耗,“以交換機芯片廠商博通發布的一款112G速率的光連接交換芯片為例,同樣驅動800G的鏈路,傳統交換機需要14W的功率,而芯片光纖直連的交換機只需要5.5W的功率,降低了約60%的能耗。”

二是更好幫助數據中心散熱的液冷技術。國內服務器廠商浪潮發布了業界首個可支持浸沒式液冷50℃進液溫度的服務器,通過更高效的系統散熱設計和熱管理技術,實現更高的進液溫度,比業內常用的40℃進液溫度系統減少了冷卻系統的部署、節省電力消耗。“液體帶走熱量的能力是同體積空氣的3000倍,液冷系統比風冷系統可以節省約30%的能源消耗,并且可以降低噪音,提供更好的工作環境。”蔣撲天介紹。為了適應液冷散熱系統,連接器和線纜也需要從材料的耐高溫、耐腐蝕,以及信號的完整性上做優化。

另外,蔣撲天指出,作為前沿技術,基于光芯片的人工智能處理器也在業界積極開發中,通過光學衍射-干涉混合等技術,甚至可以為毫瓦級低功耗自主智能無人系統提供算力支撐。

四、人工智能的應用正在哪些領域鋪開?有哪些已經在發生的應用和改變,以及哪些極具潛力的方向?

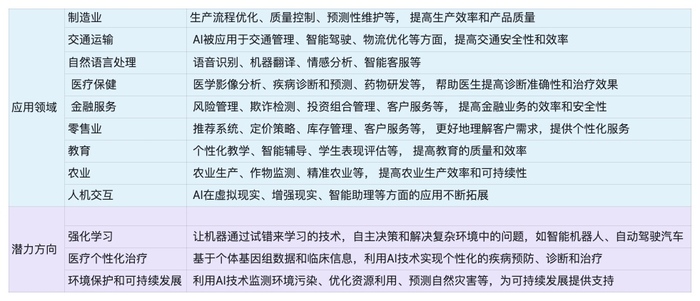

人工智能在制造業的應用可以幫助優化生產和采購流程,維護供應鏈穩定,提高生產效率和產品質量;在醫療保健領域的應用可以提高影像分析的診斷準確性,擴大醫療服務受益人群;在農業領域的應用則可以幫助農業生產進行作物監測,提供更精準的施肥、灌溉策略等。

蔣撲天基于他的觀察對人工智能已經應用的領域,和潛力方向做了簡單的分享。

第十四屆全國人大常委會委員、國家氣候變化專家委員會副主任王毅就曾表示,AI產品消耗的電力對社會來說是否是負擔,需要總體來看,“AI帶來的創新能力是我們過去人力所不可比擬的”。

美銀美林預計,AI的電力使用量將在2023年至2028年間以25-33%的年復合增長率增長,這一增長將對數據中心的設計和運營帶來挑戰。

2024年3月21日,聯合國大會通過首個關于人工智能的全球決議《抓住安全、可靠和值得信賴的人工智能系統帶來的機遇,促進可持續發展》,“能耗”只是人工智能可持續發展中的其中一個問題,也是人工智能技術與產業發展的基礎,人工智能的發展也須平衡環境、資源與氣候的關系。