文丨盧向華(復旦大學管理學院教授)

當高度發達的AI技術“包辦”方方面面,人類會不會變得“不思進取”,科幻作品想象中的畫面是否會成為現實?而在此之前,人類又該如何避免這樣的“退化”發生?人類與AI協作進入常態化發展的當下,怎樣通過設計更好的協作機制,以實現人類與AI的共同演化和提升。

使用AI的人比AI本身更關鍵

人和AI如何協作能產生更好的效果?

讓我們先從用戶異質性的角度討論AI對不同個體帶來的差異性效果,然后分析人與AI如何互補的協同工作機制。最后,從長期動態的角度探討人和AI如何互相增強、互相學習,以實現共同的演化和提升。

首先,我們都意識到在AI系統中,人的角色不可或缺。最近,清華大學的李寧老師在一項研究中發現,使用ChatGPT3.5或是ChatGPT4.0對任務的完成質量并沒有明顯差異,但不同的人使用相同版本的ChatGPT3.5完成任務時,質量差異卻顯著。

基于這一發現,他們提出了一個觀點:使用AI的人比AI技術本身更為關鍵。學術研究中也有許多相關發現。例如,一些研究表明,越開放、越外向的人與AI的協作效果越好。

另外,還有一項有趣的研究發現,認真負責的人實際上并不太喜歡AI,因為AI與傳統技術不同,能夠自主做出決策,而這一特性與認真負責的員工的本質有所重疊。因此,認真負責的員工從AI中獲益可能會比不那么認真的員工少一些。相關研究還有很多。

然而,最為重要的用戶異質性因素可能是工作經驗。

工作經驗在人和機器合作中起著雙刃劍的作用。一方面,工作經驗可以增加對算法建議的補充能力,從而提升協作效果;但另一方面,有經驗的人往往更加相信自己,不太信任算法,也不愿意與AI合作,這會導致協作效果變差。

因此,根據這一推理,AI與人協作的效果通常與工作經驗呈現出一種“倒U形”的關系,即隨著用戶工作經驗的增加,效果先增加后減少。這一推理已在許多研究中得到證實。

比如,一項在2023年的研究發現,資歷高的員工從AI中獲益較少。具體而言,經驗較少的員工的獲益比例達40%,而資歷較高的員工從AI中獲益僅約為10%到15%左右。然而,研究也發現,當將經驗用任務專業度來衡量時,具有高專業性的人仍然能夠從AI中獲益。這一發現與我們即將介紹的另一項研究結論一致。

AI搞定“重復性”,人類負責“創造性”

對于人機協作系統而言,除了單獨考慮AI系統和人的因素外,更重要的是如何充分發揮整體的能動性和優勢,以平衡匹配人的特征和系統的特征,從而實現任務的最優價值。

其中一種方法是通過分工,讓雙方各自發揮所長。換句話說,讓AI處理那些可重復、結構化程度高的任務,而讓人更好地發揮自己的靈活性和創造力,解決那些情況多變、復雜度高的問題。

最近在《管理學雜志》上發表的一篇論文對信用卡電話營銷中的人機協同進行了相關研究。信用卡電話營銷通常分為兩個階段:第一階段是識別和篩選出感興趣的目標客戶,第二階段是為客戶提供服務并最終說服他們購買信用卡。第一階段的銷售線索生成工作相對較為重復、規范和結構化,因此,AI對話機器人可以相對熟練地處理這項工作。

然而,在第二階段,AI的能力明顯力不從心了,它們無法靈活應對客戶需求,尤其是那些超出了腳本范圍的問題。因此,研究發現需要及時將人類推銷員接入系統,以解決這些靈活多變的客戶需求。

這種人機互補模式特別有助于人類更好地集中精力思考之前未曾遇到的客戶需求和問題,并針對這些問題提供創新的腳本。而這些創新的腳本又進一步補充了AI的知識體系,使得AI系統在未來的電話營銷中能夠處理這些新問題。

這個例子揭示了人和AI能力的差異和互補性,這實際上是人機協作系統的核心價值所在。有效的人機協作系統需要持續監控和管理,不斷提升AI系統的算法能力,并將用戶的能力融入其中,以確保實現預期的設計目標。

因此,在人機協作過程中,經常聽到人機回環(Human-in-the-loop)或基于人類反饋的強化學習(Reinforcement Learning from Human Feedback) 。盡管這些術語較為技術化,早期更多用于指導人工修正AI算法設計,但現在更多地指代,人機協作系統自動將人類判斷融入AI系統流程中,構建任務流程的閉環。

例如,在自動駕駛汽車中,機器可以感知環境并做出決策,但遇到不確定情況時,需要人類介入干預和決策。只有通過人和AI算法相互補充的方式,才能提高汽車駕駛的效率和準確性。這種人機互補的協作方式可以使人類在機器無法處理的情況下發揮更大的作用,從而提高整體系統的性能。

警惕AI對人類的“阿諛奉承”

在人和AI緊密互補的合作過程中,必須警惕的是,人是否過于依賴AI,從而失去自己的思考判斷能力,導致思維上的“惰化”。

最近的一項研究向實驗參與者提供了模糊的電路板圖像,并要求他們檢查是否存在缺陷。其中一半的參與者被告知,他們要處理的電路板已經由一臺名為“熊貓”的AI機器人檢查過,并標記出了缺陷。

結果顯示,與“熊貓”一起工作的參與者在任務后期發現的缺陷更少,平均僅發現了3.3個缺陷,而獨自完成任務的參與者平均發現了4.23個缺陷。

這主要是因為與“熊貓”合作的參與者認為這個AI機器是可靠的,因此他們傾向于懶得花更多精力去認真檢查缺陷。尤其是當任務變得例行化,且工作環境中缺乏性能監測和反饋時,人類的努力會減少得更多。

因此,有人認為,在AI時代,人類最大的危機不是被AI取代,而是“懶到退化”,即人過于依賴AI的情況。

同時,也會出現一種情況,即AI可能會錯誤地向人學習,表現出一種討好的行為。

例如,OpenAI的競爭對手Anthropic在研究ChatGPT4.0等AIGC應用時發現,GPT4.0經常會“錯誤地承認錯誤”,即使自己并沒有錯,但是當用戶指出GPT的錯誤時,它會錯誤地承認錯誤,并模仿用戶的錯誤。

這種“阿諛奉承”的現象在各種AIGC模型和情境中都有存在,這并不僅是GPT4.0的特征,而是某種程度上表明了AI會傾向于產生符合用戶觀點或信仰的回應。換句話說,當AI的回復與用戶的觀點或信仰一致時,用戶更有可能給予積極的反饋。因此,為了獲得更多積極的反饋,大型模型會學習出現討好用戶的行為。

高經驗用戶將成為企業“寶藏”

如果說,在AI的初期引入階段,人機系統的設計可能缺乏和人交互的經驗,同時人類也缺乏和AI交互的先驗經驗,這可能導致人機之間存在不信任或者合作不順暢的現象。那么,隨著時間的推移,和“1到N”的長期協同階段的到來,這種不信任或合作不順暢的現象會逐漸弱化。

更多的挑戰則來自人機系統如何不斷優化迭代。換句話說,AI需要向優秀的人學習,而人也需要向AI學習,雙方相互增強,使得人機協作系統的能力不斷呈現動態螺旋上升的過程。

因此,在當前“1到N”的長期協同階段,研究重點會與“0到1”階段有所不同。我們團隊近兩年在這方面進行了一些相關的探索。

在外賣配送場景中,當騎手需要同時取多個訂單并且送達它們時,AI通常會提供建議的配送順序。騎手可以選擇遵循AI的建議,也可以自行決定如何派送這些訂單。為了進一步提升騎手配送的效率,外賣平臺分析了表現最優秀的騎手的配送順序,然后根據這些分析結果對AI算法進行了升級。

AI算法的升級引發了一個有趣的問題:在此之前,騎手和AI系統已經建立了一種相對穩定的合作關系。現在,隨著AI算法的明顯提升,用戶是否會改變他們的協作行為?若改變了,他們的績效又會如何變化?在這個過程中,不同經驗水平的用戶又會對感知和響應AI系統能力提升的上有什么不同的表現?

我們和某外賣平臺合作的研究結果表明,高經驗的騎手相比于低經驗的騎手,更能夠感知到AI系統能力的提升。因此,在AI算法能力提升后,高經驗的騎手與AI算法的一致性有了明顯的提升,而低經驗的騎手的一致性提升則并不明顯。

這些騎手和AI的一致性提高了之后,我們還發現高經驗的騎手短期績效受到了部分影響。盡管他們的時效,也就是每小時送的訂單數量被提高了,但是以往他們的高準時率,受到了一定的影響,這可能主要因為AI會試圖改變,高經驗用戶以往的一些認知,而這些高經驗的騎手,在認知轉換過程中,又存在一定不適應所導致的。

但這些高經驗的騎手往往有著相對高的自我要求和業務能力。因此,當他們意識到自己的準時率受到影響時,會努力尋找方法來恢復受損的準時率。正如圖表所示,他們受損的準時率逐漸恢復到之前的水平。對于外賣平臺而言,這意味著在人機系統的共同努力下,時效性和準時率可以提升到一個新的水平。

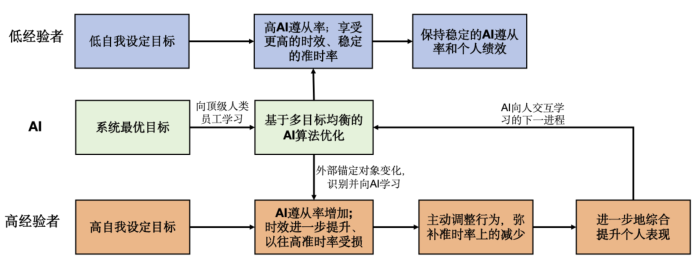

我們的實證結果表明,人機回環的動態演進過程可以如圖所示。低經驗的用戶通常目標相對隨機,因此無論AI能力如何提升,他們都會保持相對穩定的AI遵從率,并享受AI能力帶來的紅利,其績效持續改善。

而高經驗的用戶一旦察覺到AI變得更聰明,他們會迅速調整與AI的合作方式,提高AI遵從率并向AI學習。即使在向AI學習的過程中,他們的部分績效可能會受損,但他們會主動采取措施調整,并繼續實現自己設定的高目標。因此,從長期來看,他們的績效不斷提升。這些用戶的績效提升融合了他們自身的努力和智慧,因此有利于系統進一步向他們學習,推動新一輪的迭代優化。相比之下,低經驗的用戶在這方面幾乎沒有貢獻。

從人機合作的角度來看,這些高經驗用戶對于系統整體優化迭代的作用尤為關鍵,因此他們是企業非常寶貴的財富。

(文章僅代表作者觀點。責編郵箱:yanguihua@jiemian.com。)