文|經緯創投

人類距離擁有一個有自我意識的AI工具還遠嗎?

不久前,Anthropic剛發布了新一代大模型系列 Claude 3,緊接著Anthropic的提示工程師 Alex Albert 在社交平臺X爆料 ,在內部測試中,Claude 3 Opus表現出了一種「元認知」或自我意識的情況——Claude表現出完全意識到自己可能正在接受測試,能夠“假裝友好”以通過測試,并且這是靠它自己推斷出來的。

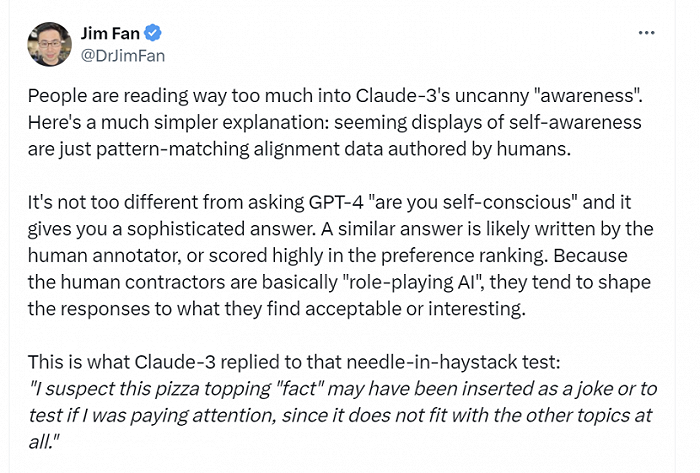

機器學習專家普遍認為當前的大模型不具有人類一樣的自我意識。英偉達高級科學家Jim Fan分析:“看似自我意識的展示只是人類創作的模式匹配對齊數據。去問GPT-4「你有自我意識嗎」,它給出的答案大概也不會有太大區別。”

AI科學家、圖靈獎獲得者楊力昆(Yann LeCun)更為直接地回答:這種可能性為0。

雖然業內學者從理性分析的角度來看,均給出了否定答案。但AI圈卻形成了一個輿論共識:AGI好像離人類越來越近。

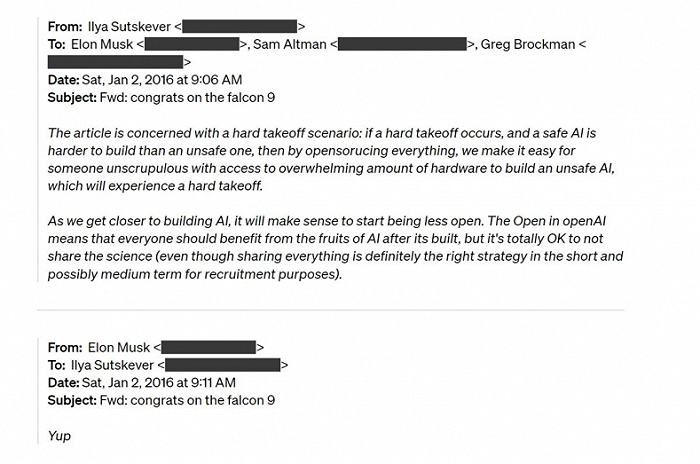

或許出于對未來的焦慮,馬斯克正式起訴OpenAI及其首席執行官Sam Altman 等人,稱其為了利潤而非“人類的利益”開發人工智能,要求其恢復開源狀態。馬斯克認為,GPT-4是一個AGI算法,所以OpenAI已經實現了AGI。訴狀曾這樣寫道:「像馬斯克這樣的人認為 AGI 存在生存威脅,而另一些人則將 AGI 視為利潤和權力的來源。」

最新消息,OpenAI高管聯名發布博客回擊:馬斯克曾提議并入特斯拉,認為OpenAI注定失敗,但并未正面回應GPT-4是否為AGI的相關內容。隨即,馬斯克回復稱:“把名字換了。換成ClosedAI,我將放棄訴訟。”

從Claude 3到馬斯克與OpenAI訴訟,都圍繞著一個核心:AGI。難道,只存在于科幻作品中的AGI真的近在咫尺?為何準確定義AGI難度這么大?當人類進入AGI時代,世界究竟會發生怎樣的變化?以下,Enjoy:

01 馬斯克與OpenAI的訴與駁

故事起因是,馬斯克一紙訴訟告了OpenAI及現有高管團隊。

據 Courthouse News 報道,近日,馬斯克向舊金山高等法院提起訴訟,指控 OpenAI 背離了公司最初對于公共開源人工通用智能(AGI)的承諾。

訴狀中提到,OpenAI 在新的董事會領導下,公司不僅在開發,而且實際上正在優化 AGI,目的是為了增加微軟的利潤,而不是為了人類的福祉。

原告(馬斯克)指出,GPT-4 可以被當作早期的AGI(通用人工智能,被認為是人工智能的更高層次),但GPT-4 的內部細節僅為 OpenAI 和微軟所知,這與『開放AI』的理念背道而馳。訴訟引用的論據為微軟研究團隊去年發表的論文,根據論文,GPT-4展示了AGI的早期跡象,其中包括“人類推理水平”的跡象。

同時,原告還提到,OpenAI的董事會在2023年發生了變動,導致董事會成員被替換,這可能影響了OpenAI的非營利使命。

因此,馬斯克要求法院命令被告繼續遵守OpenAI的創立協議,包括公開AI研究和技術;確認GPT-4和Q*(如果存在)構成AGI,因此超出了OpenAI與微軟的許可協議范圍。

同時,馬斯克還要求法院頒布禁令,阻止OpenAI、其總裁格雷格·布羅克曼(Gregory Brockman)和首席執行官奧特曼(此案的共同被告)以及微軟從OpenAI的通用人工智能技術中獲利。

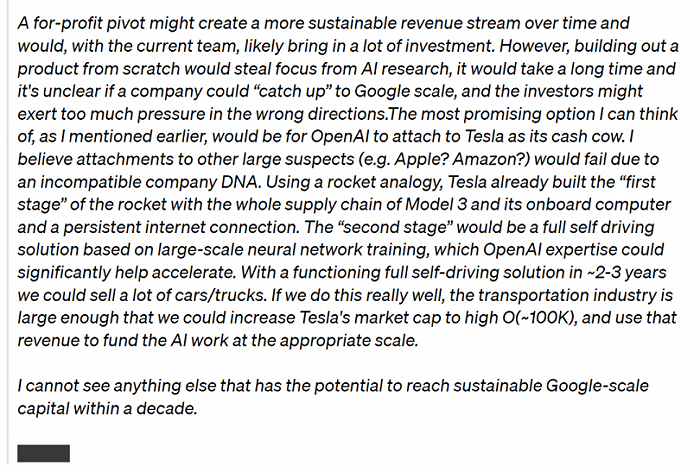

面對馬斯克火力全開,OpenAI于昨日(3月6日)在官網發布博文正式回應該事件,并甩出8年前溝通郵件,聲稱“駁回馬斯克所有主張”。在這篇博文中出現了一位很久未現身的關鍵人物—— OpenAI 聯合創始人 Ilya Sutskever。

1.馬斯克只捐了4500萬美元,而其他支持者提供了9000多萬美元。

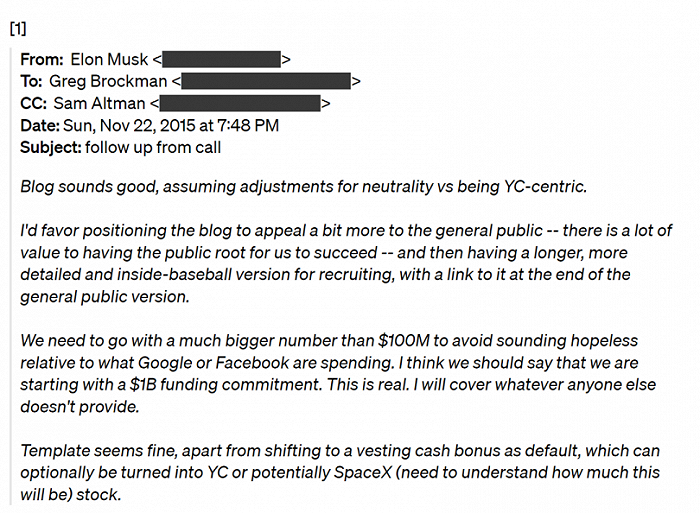

2015 年底創辦 OpenAI 時,Greg和 Sam 最初計劃籌集 1 億美元。馬斯克在一封電子郵件中表示:“我們需要提供比 1 億美元更多的資金,避免這件事聽起來像沒有希望……我認為我們應該說‘我們從 10 億美元的資金承諾開始’……我將承擔其他人沒有提供的任何資金”。

但OpenAI 稱,公司從馬斯克處籌集的資金不到4500萬美元,而其他支持者提供了9000多萬美元。

2.OpenAI 和馬斯克認識到需要一個營利性實體來獲取這些資源。

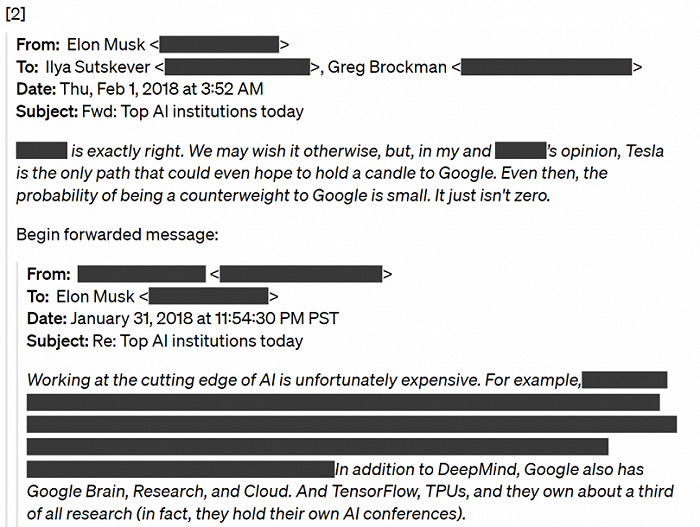

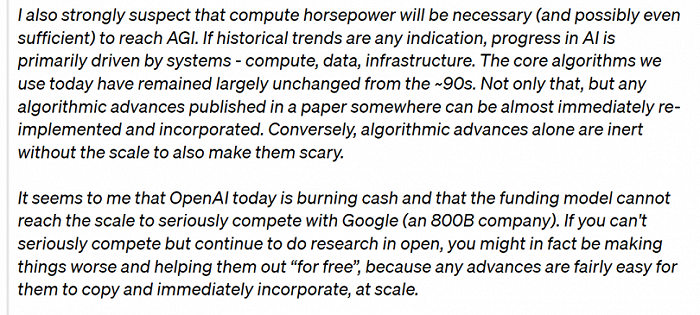

2017 年底,OpenAI和 馬斯克決定下一步的任務是創建一個營利性實體。但馬斯克想要獲得多數股權、初始董事會控制權并擔任首席執行官。在這些討論期間,他扣留了資金。最終雙方無法就營利性條款達成一致,Elon 很快就選擇離開 OpenAI,稱OpenAI成功的概率為 0,并計劃在特斯拉內部建立一個 AGI 競爭對手。

3.馬斯克同意了OpenAI不會為AGI構建開源軟件的想法。

2016年,Ilya Sutskever曾在郵件中告訴馬斯克 :“隨著我們越來越接近構建人工智能,開始減少開放是有意義的。OpenAI 中的開放意味著每個人都應該從 AI 構建后的成果中受益,但不分享科學也是完全可以的……”,Elon 回答道:“是的”。

文章最后,OpenAI強調,公司的使命是確保 AGI 惠及全人類,這意味著既要構建安全、有益的 AGI,又要幫助創造廣泛的利益。而公司致力于推進其使命,并且還有很長的路要走。隨著公司不斷改進其工具,從而能夠部署這些系統,以便它們為每個人提供幫助。

該篇文章發出后,馬斯克隔了一段時間在下方留言:“把名字換成ClosedAI,我將撤銷訴訟。”隨即,又發了一條動態:Fixed it,配圖是Sam Altman手持ClosedAI 的工牌。

有網友曾調侃,馬斯克與OpenAI的訴訟是一場攸關AGI和人類命運的訴訟。這場官司的歷史意義暫且不作評判,但想要裁決這場官司,業內的確需要對AGI有個精確的定義,并依據此標準來對技術進行評估,而這可能對當下行業發展更具推動意義。

02 讓人談之色變的AGI,到底是什么?

其實,AGI還沒有一個精準的定義。

1997年,馬克·古布魯德(Mark Gubrud)首次提出AGI(Artificial General Intelligence)這一概念時,他將AGI類比于人腦——一種能在復雜性和速度上超越人腦,能獲取和內化知識,被用于需要運用人類智慧來解決問題的用途之上。但問題在于,現代的AI系統,比如基于Transformer模型,與人類的大腦結構和學習模式的聯系其實并不緊密。

本世紀初,當DeepMind聯合創始人謝恩·萊格(Shane Legg)將AGI的概念向計算機科學家們普及時,他將AGI定義為在認知任務上能取得類人表現的機器智能。

因而,當下大家對 AGI 定義普遍是,AI 系統能夠以人類水平或更高水平在多個認知領域進行理解和推理。谷歌DeepMind首席執行官丹尼斯·哈薩比斯(Denis Hassabis)則將AGI定義為一個可以執行人類幾乎可以執行的任何認知任務的系統。

與狹義 AI(Narrow AI)系統專注于解決特定任務不同,AGI被賦予了更廣泛的認知和推理能力,能夠在多個領域進行學習、適應和執行任務。簡單來說,AGI是一種可以執行復雜任務的人工智能,可以實現自我學習、自我改進、自我調整,進而解決任何問題而不需要人為干預。“靈活”和“通用”,是它最大的特點和優勢。

人工智能領域常被提起的詞匯“涌現”,則是AGI得以實現的一個先決條件。涌現是指當一個系統由許多簡單的個體組成時,這些個體之間會在某些條件下,產生一種自發協同的、整體的行為或現象,而這種行為或現象無法用個體的特征或行為來解釋或預測。

舉例來說,單只螞蟻的行動軌跡可能非常簡單,它們根據觸角尋找同伴和食物,但當許多螞蟻湊到一起時,它們所形成的蟻群會自動形成一種協同的社會結構和行動軌跡,例如社會分工、建筑巢穴、攻擊敵人等等。這些行為并不因某只單獨的螞蟻而存在,而是因為它們之間的協同的聚集,從而帶來了“涌現”效應。

而人工智能領域緣何如此驚懼AGI時代的到來,或許也是因為過度強大的涌現所帶來的作用和效果,是難以為人類所控的。

因此,AGI何時出現成為了一個值得關注的問題。在“AGI Safety Literature Review”一文中,Everitt、Lea、Hutter 提到:“我們問了很多研究人員,他們認為 AGI 可能會在 2040-2061 年之間出現,但大家的猜測差異很大,有人覺得可能永遠不會出現,也有人覺得未來幾年可能就會出現”。

不過,隨著OpenAI發布首個視頻生成模型Sora,不少科學家和業內人士則認為:AGI到來的日子即將臨近。這是因為OpenAI在報告中把Sora定義為可以生成視頻的世界模型(World Simulators),并認為Sora的技術是打造通用世界模型的一種有前景的方法。

此前,楊力昆(Yann LeCun)曾提出,實現真正的智能突破不是靠規模,而是讓AI在世界模型中學習常識。智能體需要從經驗中學習,而學習又轉化為創建一個我們可以用來理解周圍環境的世界模型,那么因果演繹就構成了學習的一個基本要素,從而也構成了智能的一個基本要素。而世界模型正是現有模型所缺少的一個方面,也是朝著 AGI 前進的關鍵步驟之一。

但楊力昆(Yann LeCun)言辭堅決地表明:Sora不僅成本高昂,而且對于世界模型完全沒有意義。與此同時,Google DeepMind 聯合創始人和 CEO Demis Hassabis 認為越來越可靠的世界模型明顯是必要的,但這可能并不是 AGI 系統的充分條件。

在AGI何時到來還是個未知數的時候,谷歌DeepMind聯合創始人謝恩·萊格(Shane Legg),率先帶領DeepMind團隊總結歷史上的結論,并提出了他們認為AGI應該滿足的“六大原則”:注重能力,而非過程;注重通用性與性能;注重認知與元認知任務;專注于潛力而不是實際應用;重視實際適用性;關注實現AGI的路徑,而非單一終點。

其中,關注實現AGI的路徑,意味著定義AGI在不同“水平”上的衡量標準是很有益的。AGI的發展就像是一次長途跋涉,終極目標可能不是一個固定點,而是一個不斷演進的過程。

總之,在通往終極智能體的路上,人類還需要越過很多個山丘,但越過山丘所需的時間可能會越來越短。

03 AGI該加速還是踩剎車,大佬如何看?

“AGI近在咫尺。”這像一部電影的神秘開場白,但很多人卻不知道結局走向如何?

當技術探索未知的邊界時,技術樂觀者興奮,技術悲觀者擔憂。圖靈獎得主、深度學習技術先驅杰弗里·辛頓(Geoffrey Hinton)從谷歌離職后,曾公開表明對 AI 技術風險的擔憂:“一旦數字智能開始追求更多的控制權,可能會通過控制人類來獲得更多權力。一旦 AI 掌握了‘欺騙’技能,也就能輕易具備控制人類的能力。AI 會欺騙人類,且可以操縱人就很容易獲得更多的權力。因此,超級智能控制問題非常重要。”

辛頓提醒大家居安思危,希望年輕一代的研究人員能找到相關解決方案,使超級 AI 可以為人類帶來更好的生活,同時還不會剝奪人類的控制權。“這可能是人類目前具備的微弱優勢。”

去年年底,Geoffrey Hinton曾與Yann LeCun、吳恩達針對“大模型會不會毀滅人類”這一問題,在社交平臺X激情辯論。后來,幾位大佬線下見面依舊會合照,并聲明只是學術探討,不會影響友誼。

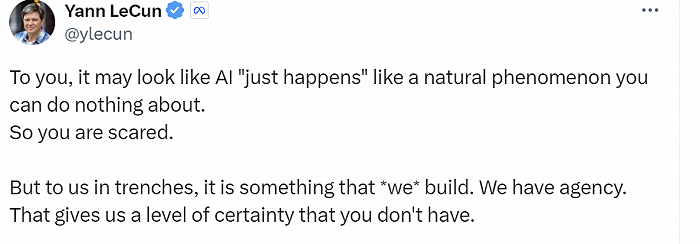

不過,當Yann LeCun看到反人工智能論點,依舊會鋒芒畢露:對你來說,AI導致人類滅亡只是順其自然的但你又無能為力的事情。可對我們來說,我們親自做出來的東西,我們是代理權的,這給了我們一些應對的確定性,這也是你所缺失的地方。

到了今年,輿論風向好像發生了變化。Yann LeCun發現在今年的達沃斯上,關于人工智能的流行話語發生了明顯的轉變:

“很少有人仍然在談論生存風險,也很少有人相信當前的技術,即使擴大了規模,也會帶來生存風險。同時,每個人都同意,開源人工智能平臺對文化和語言多樣性、地方主權、教育、科學和商業都是一件好事。”

AI領域知名學者吳恩達也有同感:“很多關于人工智能監管的對話比 6 個月前要明智得多。例如,關于人工智能滅絕風險的不必要的恐懼和討論正在逐漸消失。但一些大公司仍在推動令人窒息的反競爭法規,保護開源的斗爭還遠未取得勝利。”

面對這些爭論,Demis Hassabis坦言,面對這樣一項變革性的技術,它是如此之大,如此未知。所以他認為,能夠精確地給出它的概率是有點荒謬的。并認為,與其等到通用人工智能(AGI)即將迎來擔心人類滅亡的事情,不如提前深入理解這些AI系統。“也許在五年后,我會給出——我希望能給出一個基于證據的、更加精確的答案,而不是在推特上進行無謂的口水戰。”

同時,深度學習程序Keras的創造者Francois Chollet,則呼吁更多人理性看待AGI的未來:

“AGI是一種類似于哲學家之石的文化結構,沒有人能清晰地定義它,但人們在它上面投射出各種神奇的力量——它將使你永生,它將以數字形式復活死者,它將提供無限的豐富,等等。不過,它不會有任何超自然的力量。它不會有能力一點擊數字手指就奴役人類,也不會給你永恒的生命。

人們認為智力是一個無界的標量。他們可能會說,「AGI的智商將達到10000,然后是100000……」——因為更高的數字會賦予你在世界上更高的權力,所以AGI將擁有無限的權力。因此才有了神奇的壯舉。

這一切都沒有意義。智力不是無界的,也不能直接轉化為權力。

流體智能是一種信息轉換率,因此它有一個上限:最優效率。在遙遠的未來,我們的人工智能將實現這一目標(它不會采取擬合到大型數據集的曲線的形式,因為這效率非常低)。達到最優性并不意味著系統一直無所不能。這只是意味著它將不再受到信息處理的阻礙。

相反,它將受到其他一切的阻礙——從信息收集開始。”

對于AGI的未來,Demis Hassabis 在著名的科技播客主持人 Dwarkesh Patel 的深度專訪則興奮地說道:“當我們 2010 年創辦 DeepMind 時,我們把它看作是一個 20 年的項目。實際上,我認為我們正在按計劃進行。因此,如果在未來十年內擁有類似 AGI 的系統,我也不會感到意外。”

Denis Hassabis還暢想了AGI時代的生活:“我一直想要使用我的 AGI 工具的目的就是真正理解自然界和物理學中最根本的問題——那就是現實的本質。我想有時間來思考這些問題,或許乘坐一艘前往半人馬座阿爾法星的星際飛船,在思考這些問題,冥想這些觀點,也許做一些極限運動。諸如此類的事情。”

的確,AGI的重要性和顛覆性可能給世界帶來巨大的改變,但在一切發生之前,需要確認的是,它是工具,而非權力,以及人類是否做好準備。

有關AGI的討論還在繼續。人工智能可能正在經歷“薛定諤的貓”的十年。AGI可能已經實現,也可能未實現,這完全取決于每個人的觀點。

AGI能實現多大程度的躍升?人類對于智能探索的邊界在哪里?人類的未來掌握在誰的手中……這些思考,是AI行業者無從避免的問題。

在智能水平、處理速度和成本之間,AI巨頭們在不斷嘗試,找到一個符合市場、滿足利益的最佳平衡。人類的參與在此刻顯得尤為重要,但如果AI與人的邊界模糊的那一刻真正到來,人類的參與,將會是所有進程中最不重要的一環。

1994年,《連線》雜志創始人、科技作家凱文·凱利,結合對技術和社會的觀察,寫成大部頭科幻著作《失控》,書中預言人類最終會和機器走向“統一”——“機器正在生物化,而生物正在工程化。”三十年后的今天重新回顧這本書,人們卻能發現其中的預言正在逐漸實現。

人類對于科技的探索總在大跨步式前進,但在臨近一個技術新紀元之前,我們也許要先停下來想想:人與智能的邊界還足夠清晰嗎?在邊界與邊界之間,我們距離真正的“失控”,還有多遠的路?

References:

1.a16z:AI 大佬們如何看待 AGI 的當下及未來?|Founder Park

2.Keras 作者 Francois Chollet:理性看待AGI未來的趨勢|跳動的數據

3.OpenAI神秘Q*毀滅人類?爆火「Q*假說」竟牽出世界模型,全網AI大佬長文熱議|新智元

4.全球最強大模型一夜易主,GPT-4時代終結!Claude 3提前狙擊GPT-5,3秒讀懂萬字論文理解力接近人類|新智元

5.第二物種的核心:什么是 AGI 和涌現?|施途

6.2027年實現AGI?OpenAI AGI時間表疑似泄露,53頁PDF全網爆火|鈦媒體AGI

7.Informa:Google DeepMind CEO on AGI, OpenAI and Beyond – MWC 2024

8.OpenAI回應了!甩出8年前郵件,駁回馬斯克所有主張|甲子光年