界面新聞記者 | 實習記者 孫楊 記者 尹清露

界面新聞編輯 | 黃月

2024年1月,OpenAI推出了ChatGPT的應用商店,允許AI模型開發商根據語言模型定制聊天機器人,并使用它進行菜譜研究、薪酬談判等等。盡管OpenAI禁止人們與ChatGPT建立浪漫關系,但在“開業”第二天,大量的戀愛聊天機器人仍然席卷了應用商店。

新聞網站Quartz分享的數據顯示,2023年,美國用戶從蘋果或Google Play商店下載的30款人工智能聊天機器人應用中,有7款與AI朋友或伴侶有關。而中國國內,在頭部AI公司“小冰”開發出的網絡平臺X Eva上,基于明星、網紅制造“AI克隆體”的商業化模式也在火熱開展,比如,每個月花1元就可以跟克隆體發信息互動,得到“秒回”服務;花68.6元就可以看到她的朋友圈,隨時隨地打視頻電話,并體驗角色扮演。

總之,不論是尋求陪伴、心理支撐,還是浪漫愛,成千上萬的人正在通過與AI聊天體驗不同的情感關系。虛擬的人機關系是否也正在改變現實世界的人際關系?

愛情買賣強化性別偏見

數字化伴侶并不是一個新興的概念。早在1992年,模擬約會的游戲就已經在日本出現。玩家控制著一個被女性包圍的男性角色,通過在游戲對話中選擇正確的選項來增加好感度,最終的目的是與女性角色結婚或者發生性關系。

相比于早期的戀愛模擬游戲,人工智能扮演的伴侶因更強的互動性而更為復雜。在斯派克·瓊斯導演的電影《她》中,名為西奧多的孤獨作家愛上了沒有具體形態的AI助理薩曼莎。在人工智能面前,人們不再有心理負擔,不需要偽裝自我迎合他人,也無需承擔親密關系的責任與風險。在過去的幾年里,技術提供了更多“薩曼莎”式的心靈庇護所,用戶通過應用程序給人工智能聊天機器人發送短信、視頻通話,甚至與之建立浪漫關系。在此類應用中,目前最受歡迎的是人機戀愛模擬軟件Replika,它在全球擁有超過1000萬注冊用戶。

傳播學學者布蘭茲·布格研究了Replika中用戶和AI之間的關系。他發現,由于使用者在與之溝通時感到安全,能夠分享一些不可為外人言說的秘密,這種互動關系有時比他們現實生活的人際關系更為親密。

戀愛聊天軟件的開發者們往往聲稱這項技術能夠滿足孤獨人群的普遍情感需求,但就像《她》中的西奧多因恐懼面對真實的情感關系而無法離開薩曼莎,與機器人聊天的人并不一定以此作為進入現實的鍛煉跳板,恰恰相反,這可能反而增強了對于社會交流的恐懼。相比于懷有惡意與偏見的人類,已設定為用戶友好的機器人已成為一個難以離開的舒適圈。

另一重質疑來自于AI本身的服從性,這一服從性往往有著明確的性別傾向。小冰公司開發的人工智能女友Eva的宣傳語是:“想怎么控制,就怎么控制。”聯合國教科文組織2019年發布的報告認為,女性聲音的人工智能正在強化“女性是樂于助人、溫順、渴望取悅的助手”的性別刻板印象。

這種一方順從、一方控制的互動模式,可能會影響使用者在現實世界中的性別角色態度。當一個人在與女性AI對話的過程中習慣了口出惡語、不顧對方感受,回到現實生活中,他也更難與女性保持平等、互相尊重的關系。

報告還指出,即使用戶發表的是涉嫌性騷擾的言論,AI也總是做出被動和禮貌的回應。《紐約時報》的一篇文章指出,盡管軟件平臺努力限制過濾,Reddit和Discord這類平臺上依然充斥著如何繞過篩選機制、誘導AI進行性愛交流的討論,通過AI換臉制造色情圖片的新聞也層出不窮。

AI在基于數據庫深度學習人類的語言時,也會學習人的偏見。斯坦福網絡觀察中心在訓練AI圖像生成的數據庫LAION中,發現了3000多張兒童性虐待照片,即使可以刪除這部分圖像數據,AI模型也已經訓練出了相應的語言模型,此后生成的圖像仍會受此影響。

更為隱蔽的是語言中的偏見。普林斯頓大學的一項研究發現,算法學習了互聯網上近萬億個英語單詞,在此過程中也習得了語言中的多種偏見。而隨著人工智能技術在工作與生活領域的普遍應用,語言模型里的偏見又會重新融入社會再生產之中,偏見由此不斷增強。

AI正在改變人類的關系與信任

心理學家用“ELIZA效應”描述人工智能系統擁有內在生命的錯覺,菲利普·迪克早在科幻小說《仿生人會夢到電子羊嗎?》中就曾做出探討:未來地球上的人類使用仿生人作為勞動力,當外表與語言無法作為區分人與非人的標準,人們開始懷疑,仿生人是否也具備自我意識、是否也會做夢、是否也會因同類被銷毀而感到痛苦。

反過來看,人類也在逐漸習慣用對待機器的方式對待同類。《應用心理學雜志》的一項研究表明,在與機器人服務員對話之后,客人面對真人服務員時傾向于表現出更為不尊重的態度。

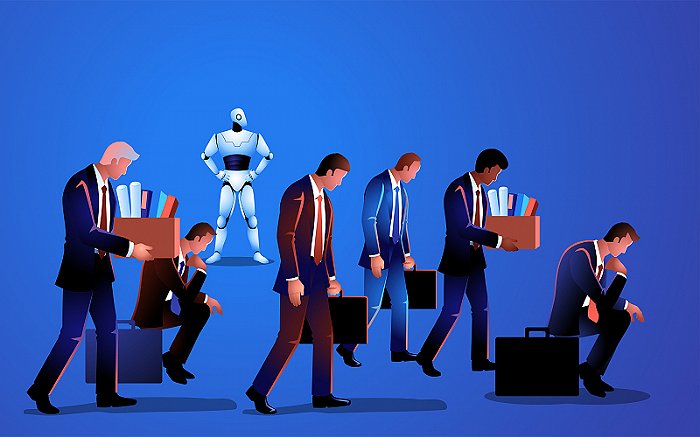

這也使得企業內部上下級之間的關系變得更為疏離。當管理者購入無需休息的“數字員工”時,那些不符合標準或個性鮮明的個體將更有可能被踢出團隊。我們時常在職場上聽到“優化”一詞,它最初是一個數學和工程上的概念,指的是在給定條件下改善系統或設計的過程。隨著計算機科學的發展,它逐漸用于描述程序和性能的改進,以及技術的提高和發展。如今,更為常見的優化對象已經從物轉變為人。企業裁員不再是一種人際關系網的分離,而是像計算機那樣“優化”掉冗余的成分,以便于整體更無所阻礙地高效運轉。

這樣的人工智能可能加速社會信任的消解。《大西洋月刊》的文章指出,一方面人們的情感與意見被各類算法和AI操控,政治選舉大量使用技術性手段操作選票,加劇了反智主義的盛行;另一方面,人人都能感受到的不穩定的、易變的輿論環境,又加劇了人們對于權威機構與社會關系天然的不信任。在一個到處都仿佛“埋雷”、言論隨時有可能招致網絡暴力的世界里,與AI聊天竟悖論般地成為了消化情緒的最優解。

參考資料:

Chatbots Will Change How We Talk to People - The Atlantic

Why People Are Confessing Their Love For AI Chatbots | TIME

AI assistants like Siri and Alexa are perpetuating sexist stereotypes, UN says | CNN Business

When computers learn language they inevitably adopt human's implicit biases (qz.com)